-

Produkterna

Hitta bland alla våra produkter

-

Andra sätt att hitta på

-

Andra sätt att hitta på

-

- 2mm för datacentret och 3mm för installationer ute i fält

- Rackstuds framtidens korgmutter

- Bredd fiberkontakter, med eller utan dragögla

- Robust fiber

- Smartkeeper kabellås och portpluggar

- Låsbart - för funktioner du älskar

- Hur fungerar en OTDR

- Kabelvindan, perfekt både akut och temporärt

- Öka driftsäkerheten med en låsbar strömkabel

- Välj rätt laddkabel för elfordon

Andra sätt att hitta på

-

Andra sätt att hitta på

-

- Överfulla soptunnor, inte längre ett problem

- Säkerställ rätt temperatur vid kyltransport

- Säkerhetskameror

- Övervakning av större områden

- Ta ditt växthus till nästa nivå

- Butiksövervakning

- Temperaturövervaka butiken med WiFi-sensorer

- Rätt luftkvalite på din arbetsplats

- Varningsljus i trafikens tjänst

- RFID-integrerade etiketter

Andra sätt att hitta på

-

- AV-presentation – Professionell konferensteknik via fiber

- AV över IP – strömmande media via Ethernet

- Videoväggar & digital skyltning

- Fiberburet AV – strömmande media via fiber

- Broadcasting – produktion och bearbetning med krav på bandbredd

- Telemedicin – höga krav på snabb kommunikation av ljud och bild

Andra sätt att hitta på

-

Andra sätt att hitta på

-

-

-

- ...

- Startsida

- Kunskapsbanken

- SFP för alla behov

- InfiniBand vs Ethernet

SFP för alla behov

-

Nätverk

-

Koaxkabel och kontakter

-

SFP för alla behov

-

Energisystem och laddning

-

Datacenter och serverhallar

-

IP-larm och fjärrkontroll

-

Test och verifiering

-

Ergonomi och komfort

-

Maximal framkomlighet i nätverket

-

Tryggare miljöer

-

Kundanpassade lösningar

-

IoT - Internet of Things

-

Tillbehör och gränssnitt

-

AV över IP

InfiniBand vs Ethernet

För att bygga effektiva datorsystem måste det finnas bra balans mellan processorkraft, hur snabbt minnet kan hantera data, och hur väl systemet kan kommunicera med kringutrustning och externa enheter. Problemet är att medan processorer utvecklas snabbt och blir kraftfullare (enligt Moore’s lag fördubblas halvledares prestanda var artonde månad) så utvecklas inte I/O-anslutningar (de som hanterar dataflödet till och från systemet) i samma takt. De är begränsade av strikta mekaniska och elektriska faktorer som inte kan skalas upp lika snabbt som processortekniken.

Det här leder till obalans i systemet där processorprestanda ökar mycket snabbare än vad minnes- och I/O-prestanda gör, vilket till slut sätter en gräns för hur effektivt hela systemet kan arbeta. Egentligen skulle vi behöva uppdatera och förändra I/O-teknologin radikalt i samma takt för att hålla jämna steg med processorernas utveckling. Men i verkligheten finns det alltså praktiska hinder som gör att I/O-anslutningar inte kan förändras lika ofta, vilket bromsar den totala systemutvecklingen.

I ljuset av det ovannämnda har InfiniBand blivit just det radikala steget mot att ta igen förlorad mark inom I/O-kommunikationen och erbjuder mångdubbelt kortare svarstider (latens) jämfört med traditionell Ethernet. Därför är inte heller InfiniBand och Ethernet direkt kompatibla med varandra, eftersom de använder olika protokoll, kablar, kontakter och kommunikationsstandarder. Dock är det möjligt att sammanlänka dessa två nätverk med hjälp av gateways, nätverkskort och specialiserade enheter.

Ethernet vs InfiniBand eller RDMA vs TCP

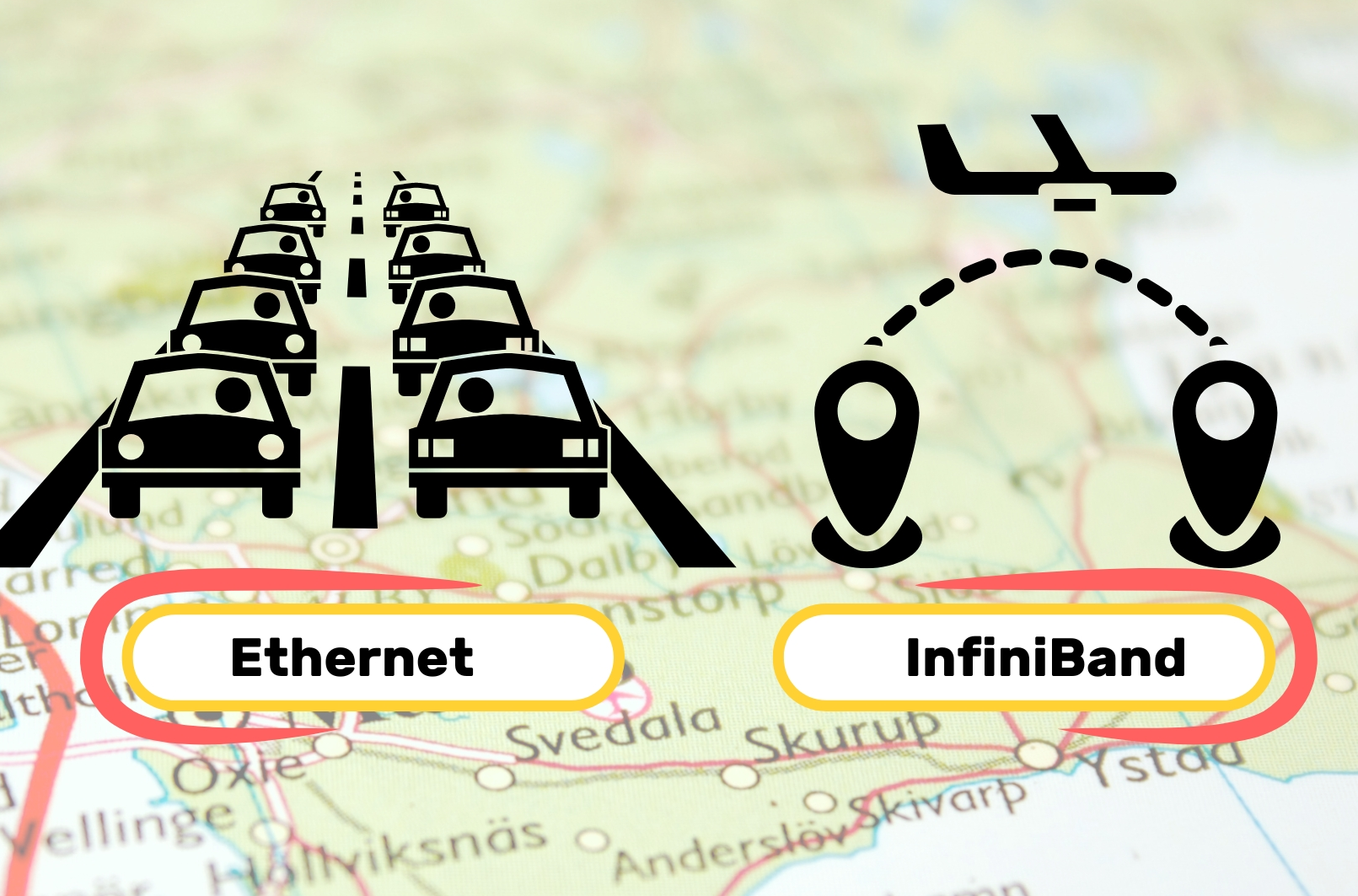

Även om jämförelsen snabbt blir orättvis och inte heller är riktigt relevant eftersom teknikerna används (och är avsedda för) olika områden, så är den oundviklig. Metaforiskt kan man säga att Ethernet är som en bred motorväg med många körfält. Den är utmärkt för att transportera stora volymer av trafik, och den klarar av att hantera olika typer av fordon (applikationer) på ett flexibelt sätt. Även om det kan bli köbildningar (längre svarstider) och att resa långa sträckor tar tid (lägre prestanda), är det en välbekant och effektiv metod som fungerar för de flesta ändamål.

InfiniBand, å andra sidan, är som att ta ett jetplan direkt till din destination. Det är snabbare, har mycket mindre väntetid (kortare svarstid), och du når ditt mål snabbare eftersom du undviker de vanliga trafikflaskhalsarna på motorvägen. Det är dock mer specialiserat och används mest när tiden är kritisk, och varje sekund räknas – precis som i högprestandaberäkning (High Performance Computing, HPC) eller superdatorer.

Vad vi menar är, att det är sättet på vilket data transporteras och kontrolleras, samt varifrån kapaciteten att göra detta tas, som är den huvudsakliga skillnaden och ger mångdubbelt kortare väntetider. InfiniBand har begåvats med RDMA (Remote Direct Memory Access) som transportprotokoll att jämföras med TCP for Ethernet. För att fullt förstå den svindlande skillnaden detta innebär får vi påminna oss om TCP.

TCP/IP och RDMA

Transmission Control Protocol/Internet Protocol (TCP/IP) är det språk som din PC och dina andra nätverksenheter pratar för att förstå varandra i ett nätverk eller över Internet. Det har använts i evigheter och är ytterst pålitligt och stabilt, men detta kommer inte utan kostnad i form av processorutnyttjande. Tillförlitligheten bygger på att den sändande enheten alltid behåller en kopia av det data som skickas, så att en omsändning kan göras i det fall mottagarens bekräftelse på att data mottagits inte når sändaren inom en föreskriven tid. Denna process, att en nätverksswitch eller PC hela tiden måste skriva och läsa till sitt eget minne för att garantera att allt data når mottagaren, kostar massor av tid och är mycket processorkrävande.

RDMA å andra sidan tillåter att du direkt flyttar data från det fysiska minnet i en enhet till det fysiska minnet i en annan, utan att involvera processorn (CPU). Istället för att den sändande enheten (som med TCP) skall behöva "be processorn" att dela upp data i mindre sändvänliga block och mottagaren på motsvarande sätt be sin processor bygga ihop blocken (IP-paketen) till det ursprungliga innehållet, öppnar RDMA en plats i minnet för hela innehållet, med en instruktion att lagra resterande delar där tills sidan är komplett.

RDMA kompenserar för tillförlitligheten som TCP erbjuder genom att använda egna mekanismer för felhantering, flödeskontroll och dataöverföring, men gör detta på en lägre nivå, direkt i RDMA-hårdvaran utan att belasta CPU. Några av dessa har namn som "Out-of-Order" (OOO) packet handling för att sortera om paket istället för att begära omsändning, Cyclic Redundancy Check (CRC) för att snabbt upptäcka fel, Zero-copy som möjliggör sändning av data som inte kräver kvittens av mottagaren.

Allt detta sammantaget, att det som tidigare skedde i processorn nu sker i RDMA-hårdvaran samt att man har egna mekanismer för felhantering, flödeskontroll och dataöverföring, gör Infiniband överlägsen Ethernet när datahastighet och svarstider är avgörande, som i dagens AI-drivna tjänster.

Nedan, en grov jämförelse mellan Ethernet och Infiniband

| Funktion/Aspekt | Ethernet | InfiniBand |

|---|---|---|

| Primärt användningsområde | Allmän nätverk (LAN, WAN, datacenter) | Högprestandaberäkning (HPC), låglatensförbindelser |

| Hastighet | Vanliga hastigheter: 1Gbps, 10Gbps, 25Gbps, 40Gbps, 100Gbps, 400Gbps, 800Gbps | Vanliga hastigheter: 40Gbps, 100Gbps, 200Gbps, 400Gbps, 800Gbps |

| Latens | Högre latens jämfört med InfiniBand (ofta i mikrosekundintervallet) | Ultra-låg latens (mätt i nanosekunder till mikrosekunder) |

| Protokoll-overhead | TCP/IP-baserad, högre protokoll-overhead på grund av komplex nätverksstack (TCP, UDP, etc.) | Använder RDMA (Remote Direct Memory Access) och lågoverhead-protokoll |

| Effektivitet | Lägre effektivitet för högprestandaberäkning eller lagringsapplikationer | Hög effektivitet, idealisk för HPC och lagringsapplikationer tack vare RDMA |

| Köhantering | Grundläggande flödeskontroll | Avancerad flödeskontroll och köhantering inbyggt i arkitekturen |

| Switching-fabric | Traditionell paketväxling, designad för allmänna nätverksmiljöer | Använder en förlustfri teknik (switchar dirigerar data med lägre felfrekvens, optimerat för högprestandatrafik) |

| Kostnad | Generellt mer prisvärt och brett tillgängligt | Vanligtvis dyrare på grund av specialiserad hårdvara och låglatensoptimeringar |

| Skalbarhet | Mycket skalbar, används i företagsnätverk och stora datacenter globalt | Skalbar inom HPC-miljöer men är mer nischad och specialiserad |

| Protokollager | OSI-lager 1 (fysiskt) till 7 (applikation), inklusive en full nätverksstack (TCP/IP) | Primärt på lager 1 till 4 (fysiskt, datalänk, nätverk, transport) med RDMA på högre lager |

| Topologistöd | Stödjer olika topologier som stjärn-, mesh- eller trädtopologier | Används vanligtvis i fat-tree, mesh eller hypercube-topologier för låglatenskommunikation |

| Applikationer | Företagsnätverk, datacenter, molntjänster, lagringsnätverk (iSCSI, NAS) | HPC-kluster, superdatorer, högfrekvenshandel, lagring (NVMe-oF, SRP) |

| Interoperabilitet | Mycket interoperabel och bakåtkompatibel med äldre Ethernet-standarder | Begränsad interoperabilitet, kräver ofta specialiserad InfiniBand-hårdvara |

| Hantering | Hanteras via standardnätverksprotokoll (SNMP, CLI, SDN) | Kräver specifik hanteringsprogramvara (t.ex. Subnet Manager för InfiniBand) |

| Felsökning | Standardmekanismer för felkorrigering (CRC, checksummor) | Förbättrad felupptäckt och korrigering för högre dataintegritet |

| Energieffektivitet | Varierande, beroende på utrustning och konfiguration | Generellt mer energieffektivt per bandbreddsenhet, optimerat för prestanda och låg latens |

Är InfiniBand alltid "snabbare" än Ethernet vid samma hastighet?

Det är inte alldeles lätt att se skillnaden på "latens" och "bandbredd", men ja InfiniBand anses snabbare i betydelsen att det erbjuder lägre latens vid samma hastighet (bandbredd).

Latensen är den tid det tar för ett enskilt datapaket att färdas från en punkt till en annan och mäts vanligtvis i mikrosekunder eller nanosekunder. Bandbredd anger den totala kapaciteten, alltså hur mycket data som kan överföras samtidigt och mäts vanligtvis i Gbps (Gigabit per sekund) eller Tbps (Terabit per sekund).

InfiniBand och Ethernet kan ha samma bandbredd, till exempel 100 Gbps, men de skiljer sig ändå åt i hur snabbt varje datapaket kan komma fram, tack vare InfiniBands lägre latens. Och som du ser av tabellen nedan så följs Ethernet och InfiniBand åt vad gäller just bandbredden.

- Single Data Rate (SDR): 10 Gbps

- Double Data Rate (DDR): 20 Gbps

- Quad Data Rate (QDR): 40 Gbps

- Fourteen Data Rate (FDR): 56 Gbps

- Enhanced Data Rate (EDR): 100 Gbps

- High Data Rate (HDR): 200 Gbps

- Next Data Rate (NDR): 400 Gbps

Kan QSFP och OSFP fibermoduler fungera med både Ethernet och InfiniBand?

Ja, trots olikheterna i övrigt så kan faktiskt fibermodulerna vara kompatibla med båda teknikerna, men dessvärre beror det på den enskilda enheten och kan inte tas för given. Vissa QSFP- och OSFP-moduler är designade för att stödja både Ethernet och InfiniBand-protokoll, vilket gör att de kan växla mellan de två beroende på det aktuella behovet. Exempelvis stöder vissa QSFP+ moduler både 40GbE (Ethernet) och 40G InfiniBand (QDR). Kompatibiliteten möjliggörs genom att konfigurera fibermodulens firmware och se till att den används i enheter som stödjer båda protokollen.

Eftersom vi på Direktronik konfigurerar alla våra moduler i eget labb här i Nynäshamn kan vi enkelt och snabbt assistera dig när det gäller konfiguration för Ethernet eller InfiniBand.

Om du vill veta mer om InfiniBand, hur du hittar rätt fibermoduler, bygger fiberinfrastrukturen eller testar och kvalificerar nät för högsta prestanda, hör av dig till oss redan idag. Vi gillar att hjälpa till och är lätta att nå på chatt, mejl eller telefon: 08 52 400 700.

Missa heller inga artiklar i Kunskapsbanken, prenumerera på nyhetsbrevet

© Copyright 2024-10-25, innehållet är skyddat enligt lagen om upphovsrätt.

Topplista

populära produkterProduktområden

-

OSFP 400Gbps transceiver för ultrasnabb dataöverföring och framtidssäkra nätverkslösningar. Hög kapacitet och pålitlighet. Beställ din transceiver nu!

-

QSFP-DD 400Gbps